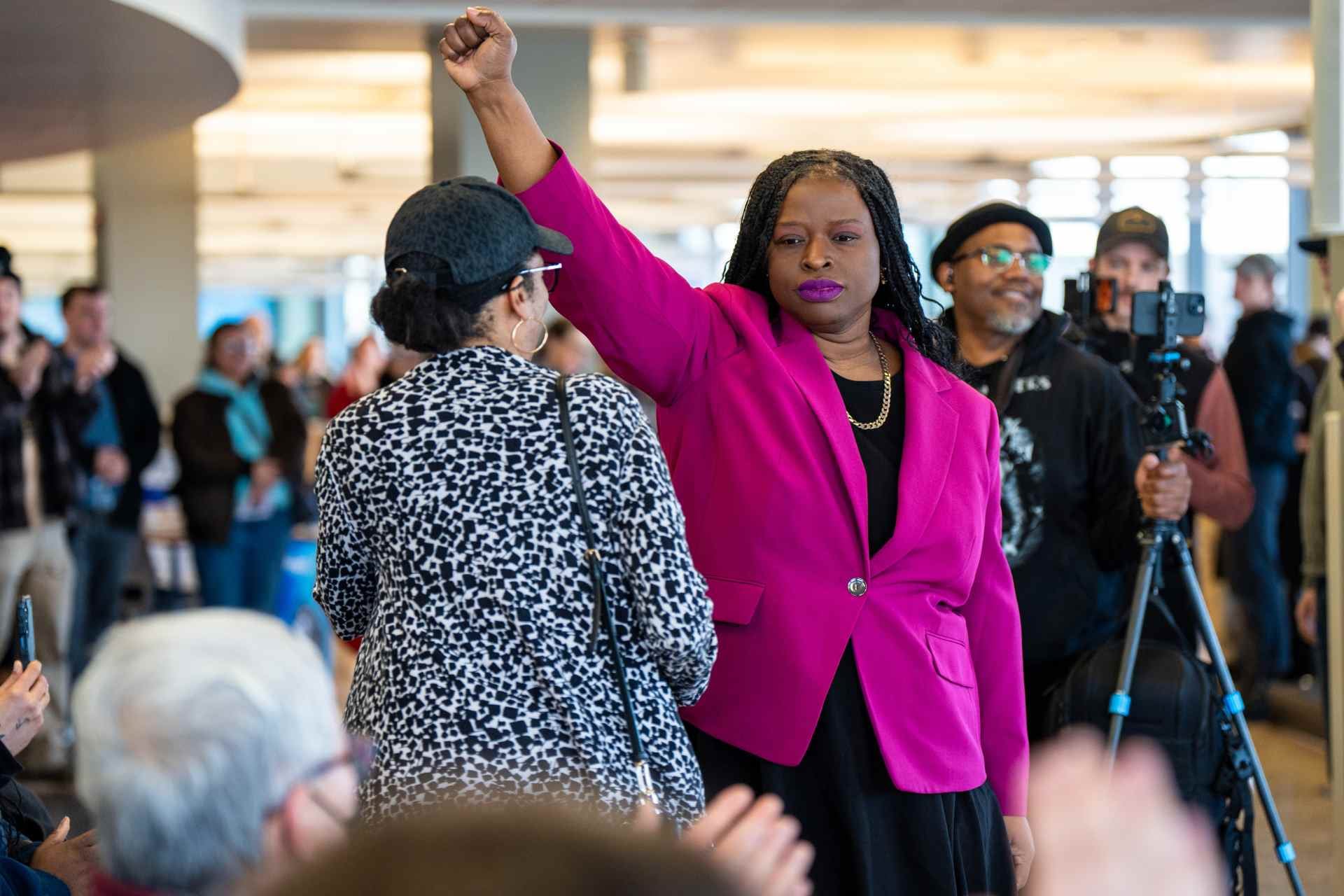

LOS ÁNGELES.- La administración de Trump no ha dudado en compartir imágenes generadas por la inteligencia artificial en línea, adoptando visuales tipo caricatura y memes y promocionándolos en los canales oficiales de la Casa Blanca. Sin embargo, una imagen manipulada pero realista de la abogada de derechos civiles Nekima Levy Armstrong llorando tras ser arrestada está generando nuevas alarmas sobre cómo la administración está borrando el límite entre lo que es real y lo que es falso.

La cuenta de la secretaria de Seguridad Nacional Kristi Noem publicó la imagen original del arresto de Levy Armstrong antes de que la cuenta oficial de la Casa Blanca publicara una imagen alterada que la mostraba llorando. La imagen manipulada es parte de un aluvión de imágenes editadas por IA que se han compartido en todo el espectro político desde los tiroteos fatales de Renee Good y Alex Pretti por agentes federales en Minneapolis.

Sin embargo, el uso de inteligencia artificial por parte de la Casa Blanca ha preocupado a los expertos en desinformación que temen que la difusión de imágenes generadas o editadas por IA erosione la percepción pública de la verdad y siembre desconfianza.

En respuesta a las críticas sobre la imagen editada de Levy Armstrong, los funcionarios de la Casa Blanca redoblaron su postura sobre la publicación, con el subdirector de comunicaciones Kaelan Dorr escribiendo en X que los “memes continuarán”. La subsecretaria de Prensa de la Casa Blanca, Abigail Jackson, también compartió una publicación burlándose de las críticas.

Expertos alarmados por desinformación

David Rand, profesor de ciencias de la información en la Universidad de Cornell, afirma que llamar meme a la imagen alterada “ciertamente parece un intento de presentarla como una broma o una publicación humorística, como sus caricaturas anteriores. Esto presumiblemente busca protegerlos de las críticas por publicar medios manipulados”. Observó que el propósito de compartir la imagen alterada del arresto parece “mucho más ambiguo” que las imágenes caricaturescas que la administración ha compartido en el pasado.

Los memes siempre han transmitido mensajes complejos que son divertidos o informativos para las personas que los entienden, pero indescifrables para otros. Las imágenes mejoradas o editadas por IA son solo la última herramienta que la Casa Blanca utiliza para involucrar a los jóvenes simpatizantes de Trump que pasan mucho tiempo en línea, explicó Zach Henry, un consultor de comunicaciones republicano que fundó Total Virality, una firma de marketing de influencers.

“Las personas que están constantemente en línea lo verán y lo reconocerán instantáneamente como un meme”, dijo. “Tus abuelos pueden verlo y no entender el meme, pero como parece real, les lleva a preguntar a sus hijos o nietos al respecto”.

Mejor aún si provoca una reacción feroz, lo que ayuda a que se vuelva viral, indicó Henry, quien generalmente elogia el trabajo del equipo de redes sociales de la Casa Blanca.

Polémica por manipulación oficial

La creación y difusión de imágenes alteradas, especialmente cuando son compartidas por fuentes creíbles, “cristaliza una idea de lo que está sucediendo, en lugar de mostrar lo que realmente está sucediendo”, señaló Michael A. Spikes, profesor en la Universidad Northwestern e investigador de medios de comunicación.

“El gobierno debería ser fuente de información confiable, de información precisa, esa es su responsabilidad”, apuntó. “Al compartir este tipo de contenido, y crear este tipo de contenido... está erosionando la confianza —aunque siempre soy un poco escéptico del término confianza— pero la confianza que deberíamos tener en nuestro gobierno federal para darnos información precisa y verificada. Es una verdadera pérdida, y realmente me preocupa mucho”.

Spikes sostuvo que ya hay “crisis institucionales” por la desconfianza en organizaciones de noticias y de educación superior, y siente que el comportamiento de los canales oficiales agrava esos problemas.

Ramesh Srinivasan, profesor en UCLA y presentador del podcast Utopias, destaca que muchas personas ahora se preguntan a dónde pueden acudir para obtener “información confiable”. “Los sistemas de IA solo van a exacerbar, amplificar y acelerar estos problemas de ausencia de confianza, una ausencia de incluso entender qué podría considerarse realidad o verdad o evidencia”, destacó.

Srinivasan dijo que siente que la Casa Blanca y otros funcionarios que comparten contenido generado por IA no solo invitan a las personas comunes a publicar contenido similar, sino que también otorgan permiso a otros que están en posiciones de credibilidad y poder, como los legisladores, para compartir contenido artificial no etiquetado. Agregó que dado que las plataformas de redes sociales tienden a “privilegiar algorítmicamente” el contenido extremo y conspirativo —que las herramientas de generación de IA pueden crear con facilidad— “tenemos un enorme desafío en nuestras manos”.

Los videos generados por IA relacionados con la acción del Servicio de Inmigración y Control de Aduanas (ICE) ya están proliferando en las redes sociales. Después de que Renee Good fuera disparada por un elemento de ICE mientras estaba en su auto, comenzaron a circular varios videos generados por IA de mujeres alejándose de agentes que les ordenan parar. También hay muchos videos fabricados circulando de redadas migratorias y de personas confrontando a efectivos de ICE, a menudo gritándoles o arrojándoles comida en la cara.

Jeremy Carrasco, un creador de contenido que se especializa en alfabetización mediática y desmentir videos virales de IA, asegura que la mayoría de estos videos probablemente provienen de cuentas que están “buscando clics” con palabras clave y términos de búsqueda populares como ICE. Pero aclara también que los videos están obteniendo vistas de personas que se oponen al gobierno y los ven como “ficción de fanáticos”, o participando en “pensamiento optimista” con la esperanza de que sean reales las imágenes de una resistencia al gobierno.

Aun así, Carrasco también cree que la mayoría de los espectadores no pueden decir si lo que están viendo es falso, y se pregunta si sabrían “qué es real o no cuando realmente importa, cuando el contenido es mucho más serio”.

Incluso cuando hay señales evidentes de generación de IA, como letreros con galimatías u otros errores obvios, solo en el “mejor de los casos” un espectador es lo suficientemente astuto o está prestando suficiente atención para saber que se trata de algo falso.

Este problema, por supuesto, no se limita a las noticias sobre redadas migratorias y protestas. Imágenes falsas de la captura del líder venezolano depuesto Nicolás Maduro explotaron en línea a principios de este mes. Los expertos, incluido Carrasco, piensan que la difusión de contenido político generado por IA solo se volverá más común.

Carrasco cree que la implementación generalizada de un sistema de marcas de agua que incrusta información sobre el origen de una pieza de medios en su capa de metadatos podría ser un paso hacia una solución. La Coalición para la Procedencia y Autenticidad del Contenido ha desarrollado tal sistema, pero Carrasco no cree que se adopte extensamente al menos por otro año.

“Va a ser un problema para siempre ahora”, aseveró. No creo que la gente entienda lo grave que es esto".